高粱米包装发展趋势-That model is currently overloaded with other requests. You can retry

高粱米包装发展趋势

当你在使用OpenAI的模型时,有时候会出现请求过载的情况,此时系统会提示“该模型当前已经超载了其他请求。您可以重试请求,或者继续联系我们的帮助中心help.openai.com,如果错误一直存在,请在消息中包含请求ID 22b800c72aee43da6a5e0c06181b5878。”本文将从三个方面来详细阐述这个问题。

一、OpenAI模型与请求

在对问题进行深入了解之前,我们需要先了解一下什么是OpenAI模型。OpenAI是人工智能领域的一个公司,该公司的模型以其高度的灵活性和精度的预测而受到推崇。这些模型可以用于各种任务,例如自然语言处理、图像识别和语音识别。

但是,这些模型需要在服务器上运行,而每个模型都有其计算资源的限制。当许多用户同时使用该模型并请求其服务时,服务器的负载可能会超出其容量,这时就会出现请求过载的问题。

如果您遇到请求过载的问题,可以先尝试重试请求。如果问题依然存在,您可以联系帮助中心的管理员,以获得更多的支持。

二、如何避免请求过载

为避免请求过载,您可以采取以下几种方式:

第一、使用专用的脚本批量发出请求。这可帮助您更好地控制请求。

第二、增大请求间隔时间。通过设置请求的间隔时间,可以让服务器有更多的时间来处理每个请求,从而减轻服务器的负载。

第三、使用更高性能的服务器。如果您具备相应的技术知识,可以尝试升级服务器来增加其计算能力。

第四、减少请求次数。尝试采用更为高效的方法,来处理请求。

三、解决请求过载的问题

当您遇到请求过载的问题时,可以采取以下几种方法来解决:

第一、等待一段时间后再尝试请求。当服务器负载降低时,您的请求可能会获得更多的资源。

第二、与管理员联系。如果问题仍然存在,请联系帮助中心的管理员,以获得更多的支持。

第三、尝试使用其他模型。如果您正在使用负载高的模型,请尝试使用其他模型进行预测。

总结:

在使用OpenAI模型时,我们需要了解其工作原理,以便更好地预测它的负载并采取相应的措施来避免请求过载的问题。如果您遇到此问题,请尝试重试请求或联系支持人员,以获得更多的支持。同时我们需要思考如何避免过载,例如使用更高的性能服务器,减少请求次数等。当然,我们也可以尝试使用其他的模型进行预测。只要我们遵循一定的原则,我们就可以高效地使用OpenAI的模型。

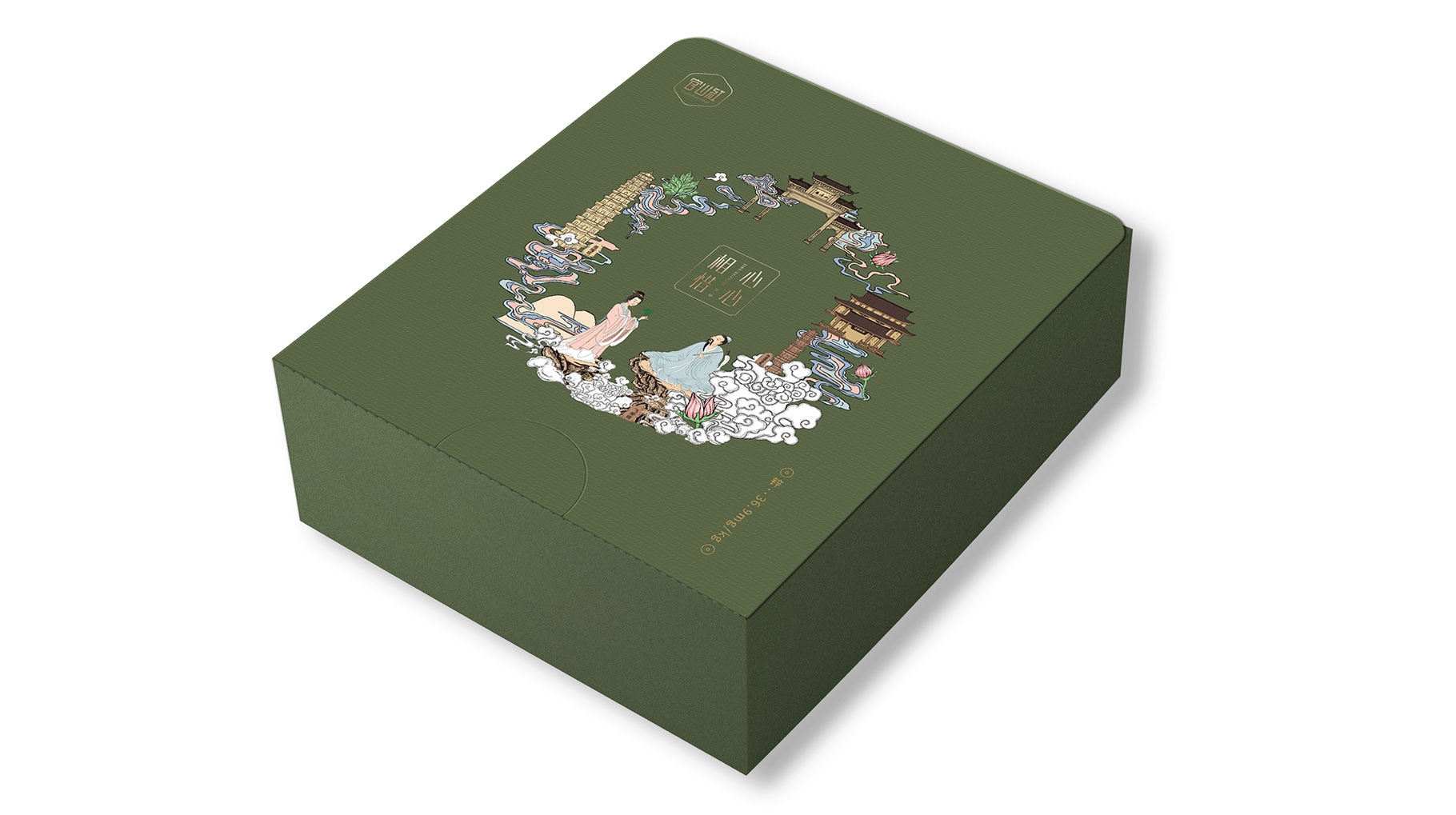

上就就是对“高粱米包装发展趋势”介绍,下面则是分享同道包装设计公司案例:

高粱米包装发展趋势配图为同道包装设计公司案例

高粱米包装发展趋势配图为同道包装设计公司案例

本文关键词:高粱米包装发展趋势